搜索

搜索

“正大期货"

扫码下载APP

作者: 正大期货 来源:https://www.xasswkj.com/ 阅读次数:次 2024-06-11 08:26 【字体: 大 中 小】

AI这“破天的富贵”,谁都不想错过。

只管摩尔定律迫近极限,芯片性能的提升变得加倍难题。但各大厂商依然以令人瞩目的速率推出新一代产物,在克日召开的台北国际电脑展上,英伟达、AMD和英特尔三大芯片巨头齐聚一堂,纷纷秀出自家肌肉,推出了下一代AI芯片。

英伟达的Hopper GPU/Blackwell/Rubin、AMD的Instinct 系列、英特尔的Gaudi芯片,这场AI芯片争霸战拼什么?这是速率之争,以英伟达为首,几家巨头将芯片推出速率提升到了一年一代,展现了AI领域竞争的“芯”速率;是手艺的角逐,若何让芯片的盘算速率更快、功耗更低更节能、更易用上手,将是各家的本事。

只管各家厂商在AI芯片方面各有偏重,但细看之下,实在存在着不少的配合点。

1、一年一代,展现AI领域"芯"速率

虽然摩尔定律已经最先有些吃力,然则AI芯片“狂欢者们”的创新措施以及芯片推出的速率却越来越快。英伟达Blackwell还在势头之上,然而在不到3个月后的Computex大会上,英伟达就又祭出了下一代AI平台——Rubin。英伟达首席执行官黄仁勋示意,以后每年都市宣布新的AI芯片。一年一代芯片,再次刷新了AI芯片的更迭速率。

英伟达的每一代GPU都市以科学家名字来命名。Rubin也是一位美国女天文学家Vera Rubin的名字命名。Rubin将配备新的GPU、名为Vera的新CPU和先进的X1600 IB网络芯片,将于2026年上市。

现在,Blackwell和Rubin都处于周全开发阶段,其一年前在2023年在Computex上宣布的GH200 Grace Hopper“超级芯片”才刚周全投入生产。Blackwell将于今年晚些时刻上市,Blackwell Ultra将于2025年上市,Rubin Ultra将于2027年上市。

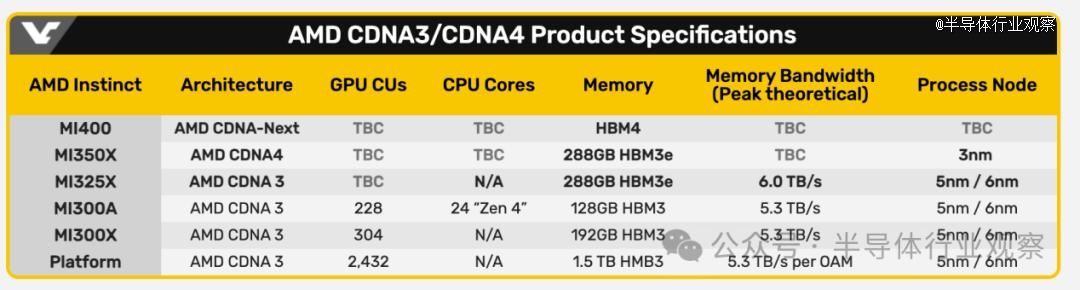

紧跟英伟达,AMD也宣布了“按年节奏”的AMD Instinct加速器蹊径图,每年推出一代AI加速器。Lisa Su在会上示意:“人工智能是我们的主要义务,我们正处于这个行业令人难以置信的激悦耳心的时代的最先。”

继去年推出了MI300X,AMD的下一代MI325X加速器将于今年第四序度上市,Instinct MI325X AI加速器可以看作是MI300X系列的强化版,Lisa Su称其速率更快,内存更大。随后,MI350系列将于2025年首次亮相,接纳新一代AMD CDNA 4架构,预计与接纳AMD CDNA 3的AMD Instinct MI300系列相比,AI推理性能将提高35倍。MI350对标的是英伟达的Blackwell GPU,根据AMD的数据,MI350系列预计将比英伟达B200产物多提供50%的内存和20%的盘算TFLOP。基于AMD CDNA“Next”架构的AMD Instinct MI400系列预计将于2026年上市。

英特尔虽然战略相对守旧,然则却正在通过价钱来取胜,英特尔推出了Gaudi人工智能加速器的起劲订价战略。英特尔示意,一套包罗八个英特尔Gaudi 2加速器和一个通用基板的尺度数据中央AI套件将以65,000美元的价钱提供应系统提供商,这约莫是同类竞争平台价钱的三分之一。英特尔示意,一套包罗八个英特尔Gaudi 3加速器的套件将以125,000美元的价钱出售,这约莫是同类竞争平台价钱的三分之二。AMD和Nvidia虽然不公然讨论其芯片的订价,但凭证定制服务器供应商Thinkmate的说法,配备八个Nvidia H100 AI芯片的同类HGX服务器系统的成本可能跨越30万美元。

一起高歌猛进的芯片巨头们,新产物宣布速率和订价凸显了AI芯片市场的竞争猛烈水平,也让众多AI初创芯片玩家望其项背。可以预见,三大芯片巨头将分食大部门的AI市场,大量的AI初创公司分得一点点羹汤。

2、工艺奔向3纳米

AI芯片走向3纳米是事态所趋,这包罗数据中央甚至边缘AI、终端。3纳米是现在*进工艺节点,3纳米工艺带来的性能提升、功耗降低和晶体管密度增添是AI芯片生长的主要驱动力。对于高能耗的数据中央来说,3纳米工艺的低功耗特征至关主要,它能够有用降低数据中央的运营成本,缓解数据中央的能源压力,并为绿色数据中央的建设提供主要支持。

英伟达的B200 GPU功耗高达1000W,而由两个B200 GPU和一个Grace CPU组成的GB200解决方案消耗高达2700W的功率。这样的功耗使得数据中央难以为这些盘算GPU的大型集群提供电力和冷却,因此英伟达必须接纳措施。

Rubin GPU的设计目的之一是控制功耗,天风国际证券剖析师郭明錤在X上写道,Rubin GPU很可能接纳台积电3纳米工艺手艺制造。另据外前言绍,Rubin GPU将接纳4x光罩设计,并将使用台积电CoWoS-L封装手艺。与基于Blackwell的产物相比,Rubin GPU是否真的能够降低功耗,同时显著提高性能,或者它是否会专注于性能效率,另有待考察。

AMD Instinct系列此前一直接纳5纳米/6纳米双节点的Chiplet模式,而到了MI350系列,也升级为了3纳米。半导体着名剖析师陆行之示意,若是英伟达在加速需求下对台积电下单需求量大,可能会让AMD得不到足够产能,转而向三星下订单。

泉源:videocardz

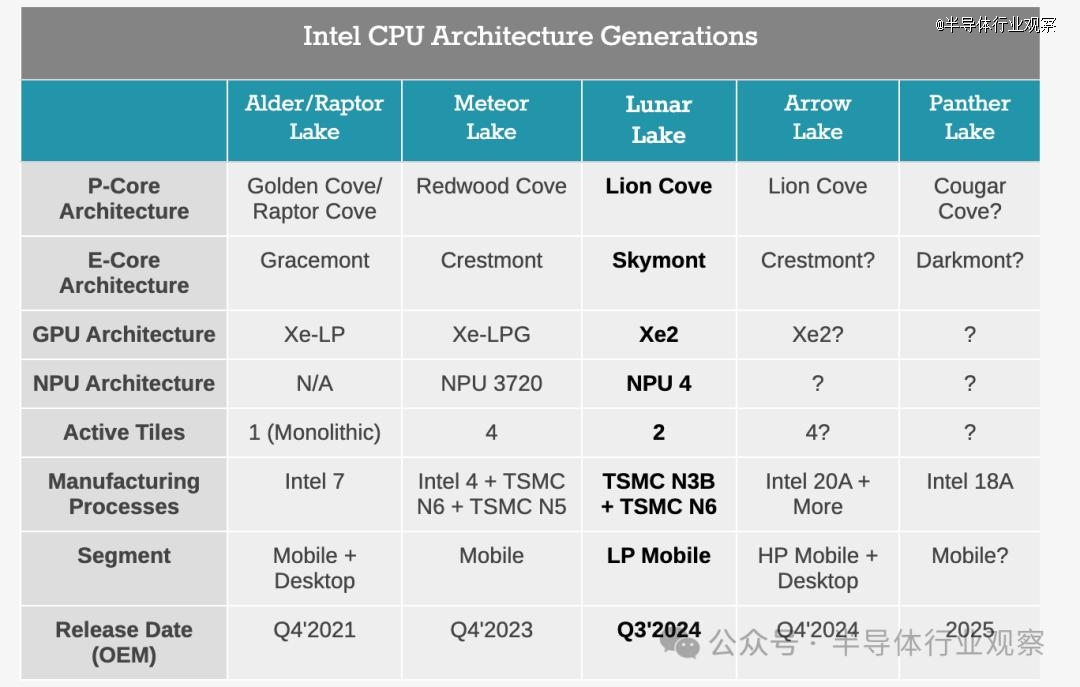

英特尔用于天生式AI的主打芯片Gaudi 3接纳的是台积电的5纳米,对于 Gaudi 3,这部门竞争正在略微缩小。不外,英特尔的重心似乎更偏重于AI PC,从英特尔最新宣布的PC端Lunar Lake SoC来看,也已经使用了3纳米。Lunar Lake包罗代号为Lion Cove的新 Lion Cove P核设计和新一波Skymont E 核,它取代了 Meteor Lake 的 Low Power Island Cresmont E 核。英特尔已披露其接纳 4P 4E(8 核)设计,禁用超线程/SMT。整个盘算块,包罗P核和E核,都确立在台积电的N3B节点上,而SoC块则使用台积电N6节点制造。

英特尔历代PC CPU架构(泉源:anandtech)

在边缘和终端AI芯片领域,IP大厂Arm也在今年5月宣布了用于智能手机的第五代 Cortex-X 内核以及带有最新高性能图形单元的盘算子系统 (CSS)。Arm Cortex-X925 CPU就行使了3纳米工艺节点,得益于此,该CPU单线程性能提高了36%,AI性能提升了41%,可以显著提高如大语言模子(LLM)等装备端天生式AI的响应能力。

投资界24h | 华为否认曾提出投资柔宇科技;iOS18发布:iPhone有通话录音了;杭州95后,估值30亿

3、高带宽内存(HBM)是必须品

HBM(High Bandwidth Memory,高带宽存储器)已经成为AI芯片不能或缺的要害组件。HBM手艺履历了几代生长:*代(HBM)、第二代(HBM2)、第三代(HBM2E)、第四代(HBM3)和第五代(HBM3E),现在正在起劲生长第六代HBM。HBM不停突破性能极限,知足AI芯片日益增进的带宽需求。

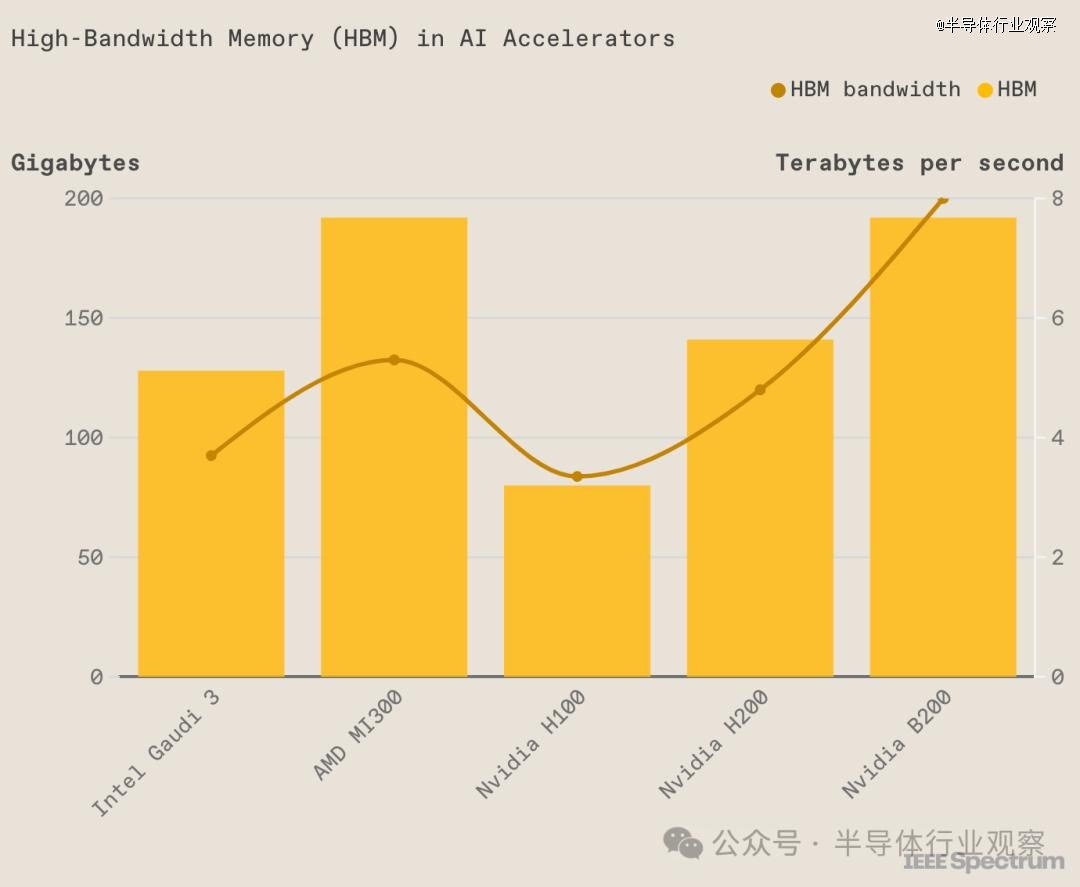

在现在一代的AI芯片当中,各家基本已经都相继接纳了第五代HBM-HBM3E。例如英伟达Blackwell Ultra中的HBM3E增添到了12颗,AMD MI325X拥有288GB的HBM3e内存,比MI300X多96GB。英特尔的 Gaudi 3封装了八块HBM芯片,Gaudi 3能够云云拼性价比,可能很主要的一点也是它使用了较廉价的HBM2e。

英特尔Gaudi 3的HBM比H100多,但比H200、B200或AMD的MI300都少(泉源:IEEE Spectrum)

至于下一代的AI芯片,险些都已经拥抱了第六代HBM-HBM4。英伟达Rubin平台将升级为HBM4,Rubin GPU内置8颗HBM4,而将于2027年推出的Rubin Ultra则更多,使用了12颗HBM4。AMD的MI400也奔向了HBM4。

从HBM供应商来看,此前AMD、英伟达等主要接纳的是SK海力士。但现在三星也正在起劲打入这些厂商内部,AMD和三星现在都在测试三星的HBM。6月4日,在台北南港展览馆举行的新闻宣布会上,黄仁勋回覆了有关三星何时能成为 Nvidia 互助同伴的问题。他示意:“我们需要的 HBM 数目异常大,因此供应速率至关主要。我们正在与三星、SK 海力士和美光互助,我们将收到这三家公司的产物。”

HBM的竞争也很白热化。SK海力士最初设计在2026年量产HBM4,但已将其时间表调整为更早。三星电子也宣布设计明年开发HBM4。三星与SK海力士围绕着HBM的竞争也很猛烈,两家在今年将20%的DRAM产能转向HBM。美光也已加入到了HBM大战行列。

炙手可热的HBM也成为了AI芯片大规模量产的掣肘。现在,存储大厂SK Hynix到2025年之前的HBM4产能已基本售罄,供需矛盾日益凸显。凭证SK海力士展望,AI芯片的繁荣动员HBM市场到2027年将泛起82%的复合年增进率。剖析师也以为,预计明年HBM市场将比今年增进一倍以上。

三星电子DRAM产物与手艺执行副总裁Hwang Sang-joon在KIW 2023上示意:“我们客户当前的(HBM)订单决议比去年增添了一倍多。”三星芯片认真营业的装备解决方案部门总裁兼认真人 Kyung Kye-hyun 在公司集会上更示意,三星将起劲拿下一半以上的HBM市场。三星内存营业执行副总裁Jaejune Kim对剖析师示意,该公司将在2023年至2024年间将其HBM产能增添一倍。

4、互联:主要的拼图

AI芯片之间互联一直是个难题,随着近年来越来越多的加速器被集成到一起,若何高效传输数据成为了瓶颈。由于PCIe手艺的生长速率跟不上时代需求,现在主流的AI芯片厂商都已经自研了互联手艺,其中较为代表的就是英伟达的NVLink和AMD的Infinity Fabric。

NVIDIA的下一代Rubin平台,将接纳NVLink 6交流机芯片,运行速率为3600GB/s,上一代的Blackwell接纳的是NVLink 5.0。NVLink设计之初,就是为领会决传统的PCI Express (PCIe) 总线在处置高性能盘算义务时带宽不足的问题。下图显示了英伟达各代NVLink的参数情形。

各代NVLink的性能参数

与英伟达的NVLink相似,AMD则推出了其Infinity Fabric手艺,AMD Infinity 架构与第二代 AMD EPYC处置器一同推出,使系统构建者和云架构师能够释放最新的服务器性能,同时又不牺牲功效、可治理性或辅助珍爱组织最主要资产(数据)的能力。Infinity Fabric支持芯片间、芯片对芯片,以及即将推出的节点对节点的数据传输。

英特尔则是以太网的坚实拥护者,英特尔的用于天生式AI的Gaudi AI芯片则一直沿用传统的以太网互联手艺。Gaudi 2每个芯片使用了24个100Gb以太网链路;Gaudi 3也使用了24个200Gbps以太网RDMA NIC,然则他们将这些链路的带宽增添了一倍,到达200Gb/秒,使芯片的外部以太网I/O总带宽到达8.4TB/秒。

5、拼服务

诸如ChatGPT这样的天生式AI开发义务极其庞大,大模子需要在多台盘算机上运行数十亿到数万亿个参数,它需要在多个GPU上并行执行事情,接纳张量并行、流水线并行、数据并行等多种并行处置方式,以尽可能快地处置义务。

因此,若何能够辅助用户更快的开发,提供优越的服务也是要害一役。

在这方面,英伟达推出了一种新型的软件NIMS,即NVIDIA Inference Microservices(推理微服务)。黄仁勋称之为“盒子里的人工智能”,NIMS中包罗了英伟达的CUDA、cuDNN、TensorRT、Triton。NIMS 不仅使部署 AI 变得更容易,只需几分钟而不是几个月,它们还组成了客户可以确立新应用程序息争决新问题的构建块。若是接纳,NIMS 将有助于加速创新并缩短价值实现时间。Nvidia 还宣布,NIMS 现在可供开发职员和研究职员免费使用。在生产中部署NIMS需要AI Enterprise允许证,每个GPU的价钱为4500美元。

6、结语

下一场AI之战已然打响,综合来看,当前AI芯片市场上,英伟达、AMD和英特尔等主要芯片巨头正在睁开猛烈的竞争。他们不仅在速率、手艺和工艺方面竞相创新,还在互联和服务等领域起劲拓展,致力于为用户提供更快、更强、更智能的AI解决方案。AI芯片争霸战仍在继续,谁能最终胜出?让我们拭目以待。

免责声明:此消息为 正大期货原创或转自合作媒体,登载此文出于传递更多信息之目的,并不意味着赞同其观点或证实其描述,请自行核实相关内容。文章内容仅供参考,不构成 正大期货投资建议。